Технологията Deepfake, именувана на процеса за машинно обучение (Deep Learning), се появи за първи път през ноември 2017 г., когато анонимен потребител в социалната медийна платформа Reddit, на име “r/Deepfake” публикува алгоритъм, който използва съществуващи модели на изкуствен интелект, за да създава реалистични фалшиви видеоклипове и снимки. След това други потребители споделиха кода в GitHub – сайт за споделяне на код, където той стана безплатен софтуер и публично достъпен. Не след дълго се появиха приложения като FakeApp, които опростиха процеса на създаване на тези изображения.

Първоначално технологията предизвика скандал, свързан с порнографията, когато подобен софтуер беше използван за създаването на нецензурни клипове и снимки на известни личности, като Гал Гадот, Дейзи Ридли и Джесика Алба. В последствие алгоритъмът беше използван за създаването на подобни материали и на известни хора от социалните мрежи, което още повече засили скандала.

Въпреки че това неетично използване на софтуера, несъмнено причинява щети на пострадалите, както споделят жертвите, технологията крие много по-сериозни опасности. През 2018 година в мрежата беше пуснат клип на бившия президент Барак Обама, в който той нарича опонента си – Доналд Тръмп, глупав и некомпетентен. В последстовое се установи, че този клип е фалшиф.

Не е лесно да се синтезират изражения на лицето на човек, само с използването на компютърна графика, още по трудно се оказва генерирането на реалистично звучащ глас, но с помощтта на изкуствен интелект и добър актьор, може да се преодолеят някои от проблемите.

Много от нас са чували на какво са способни умели актьори и колко добре могат да имитират гласа на „жертвата“. До скоро това не беше проблем, но с навлизането на алгоритмите за изкуствен ителект, тези хора могат толкова добре да се представят за някой друг, че средностатистическият слушател да бъде заблуден.

Освен за подвеждаща пропаганда, тези клипове и видеа могат да бъдат използвани и за различни типове измами, например наскоро известният подкастър – Джо Роугън, беше използван в deepfake видео, в което се вижда как говори с учстник в своето шоу, промотирайки продукт, за който се оказва че реалният човек дори не е чувал.

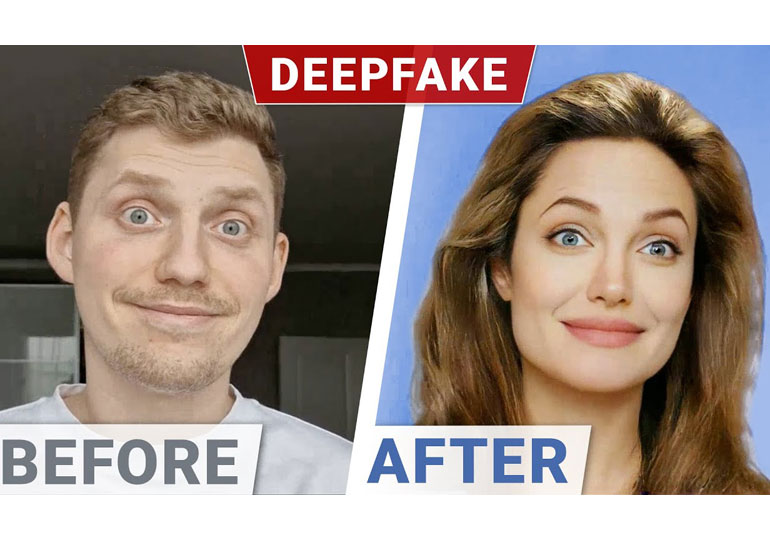

Но как тези видеа остават незабелязани и защо са толкова добри? Тайната се крие в огромното количество данни с които разполагаме за определения човек. Например гореспоменатият Джо Роугън има хиляди клипове в спотифай, на които е заснет под множество ъгли, говорещ всевъзможни неща. Алгоритъмът за изкуствен ителект „преглежда“ тези видеа и изгражда модел („маска“) на определеният човек. От там актьор бива заснет как говори това, което искате да припишете като казано от „звездата“. След това на компютър лицето му бива сменено с маската, генерирана от изкуствния интелект и имате видео, на което сякаш известната личност говори, но всъщност казва това, които вие искате.

Проблемът идва от там, че нищо не може да се направи, за да се забележат този тип генерирани изображения, тъй като колкото по-добър софтуер правим за да ги „хващаме“ или раличаваме от реални видеа, толкова повече „обучаваме“ алгоритъма да ги прави по-реални.

Въпреки това не всичко е толкова деструктивно. Например, подобна технология се приложи наскоро в Холивуд, във филма на Star Wars – Rogue One, кадето технологията беше използвана за да „възроди“ вече починалия актьорът Alex McCrindle, който играе генерал “Tarkin”.

Дори вече е започнало изграждането на база с актьорски маски на все още живи актьори, които да могат да бъдат използвани в киното в бъдеще. Няма еднозначен отговор за момента, къде седи законът отностно авторските права върху тези данни. Аз лично мисля, че трабва да са собственост на човека чието лице е изобразено върху маската, в противен случай рискуваме бъдещи скандали, като този с холивудските звезди.